STIMULUS

La solution MBSE de bout en bout et d'automatisation des tests

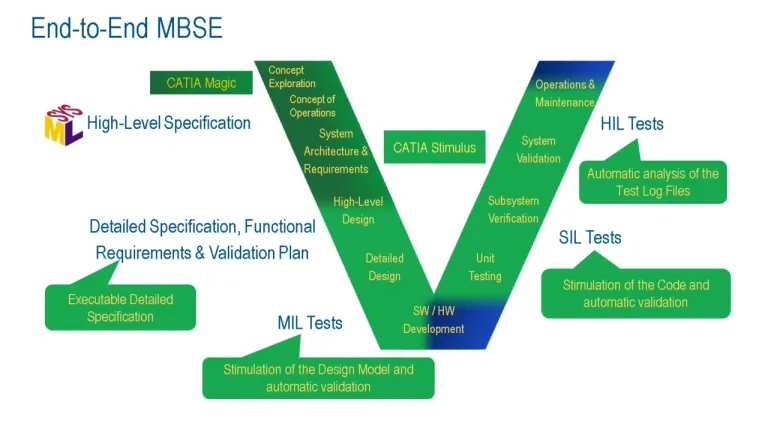

Qu'est-ce que l'approche MBSE de bout en bout ?

L'approche MBSE classique porte généralement sur l'utilisation de SysML lorsque les exigences sont saisies sous forme de texte brut. Par conséquent, celles-ci ne font pas partie de la vérification ni de la simulation. Comme elles sont au format texte brut, aucun élément ne peut être généré. Il est donc nécessaire de créer manuellement chaque scénario de test à partir de chaque exigence fonctionnelle.

STIMULUS est porteur d'un nouveau paradigme, car il étend les fonctionnalités de modélisation aux exigences fonctionnelles. 100 % du comportement du système peut être capturé, ce qui se traduit par de nouvelles possibilités d'automatisation des tests : les scénarios sont capturés et le solveur des contraintes de STIMULUS les utilise ensuite pour générer autant de combinaisons d'entrées que nécessaire. Ces vecteurs de test permettent de stimuler la spécification et, par la suite, le code. STIMULUS observe la réponse du code et la compare au comportement défini dans les exigences, automatisant entièrement le test fonctionnel. Lors de la phase d'intégration, STIMULUS analyse le fichier journal généré par l'environnement de test HIL et compare le comportement du système intégré aux exigences, ce qui permet au testeur de détecter automatiquement toute violation.

Automatisation des tests fonctionnels

Le code est stimulé par les vecteurs de test qui sont automatiquement générés par STIMULUS. Les sorties sont observées par le logiciel, qui les compare aux relations attendues entre les entrées et les sorties, conformément aux exigences. Il est possible de générer et d'exécuter automatiquement un grand nombre de tests tandis que STIMULUS assure le suivi des exigences.

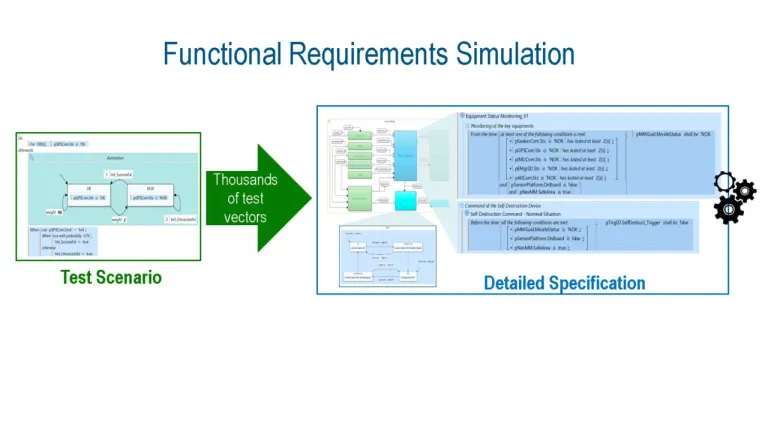

Simuler et valider vos exigences fonctionnelles

STIMULUS permet aux architectes système d'étendre l'utilisation des modèles SysML aux exigences fonctionnelles qui peuvent, pour la première fois, être simulées et validées. Les utilisateurs ont ainsi la possibilité de détecter et de corriger à un stade précoce de nombreuses erreurs, telles que des exigences manquantes, conflictuelles ou erronées. Les équipes de développement gagnent en efficacité, car elles reçoivent des exigences claires, complètes et validées.

Les équipes de validation n'ont pas besoin de dériver manuellement chaque scénario de test fonctionnel à partir d'une exigence fonctionnelle. Avec STIMULUS, le test du code ou du système par rapport aux exigences associées est entièrement automatisé, offrant un formidable retour sur investissement, car un nombre nettement plus important de tests sont générés et réalisés avec bien peu d'efforts.

.

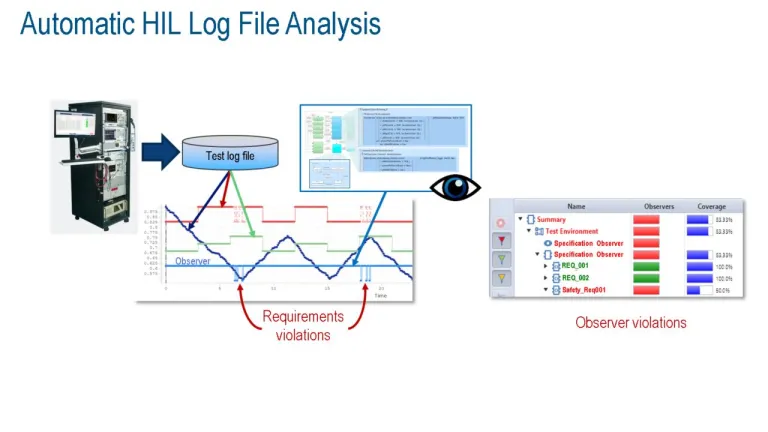

Tests HIL

STIMULUS prend en charge le test du système intégré en analysant automatiquement le fichier journal généré par les environnements de test. Ce fichier contient les E/S qui se sont produites au cours des tests. STIMULUS compare les données aux exigences et détecte automatiquement toute violation.

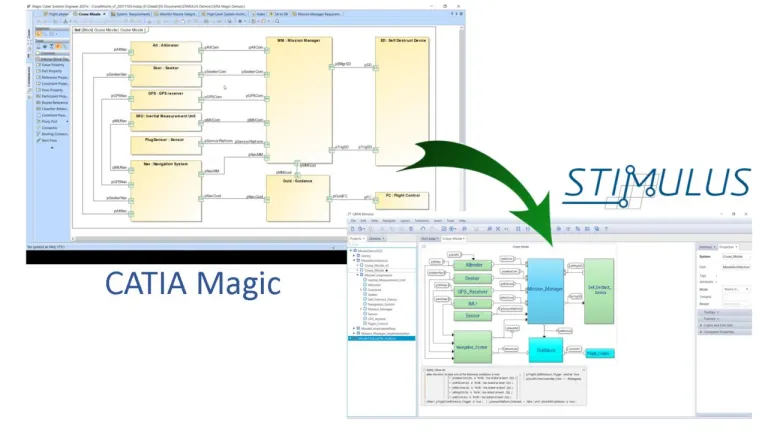

STIMULUS et CATIA Magic

STIMULUS étend l'utilisation des modèles au comportement détaillé, difficile à capturer dans SysML. La continuité numérique entre CATIA Magic et Stimulus est assurée, car il est possible d'importer l'architecture SysML (et les signaux associés) dans STIMULUS où le comportement détaillé est capturé, simulé et validé.

Rejoignez la conversation dans la communauté d'utilisateurs des cyber-systèmes MBSE CATIA

À découvrir également

Découvrir comment CATIA peut vous aider

Contactez un expert CATIA pour découvrir comment nos solutions permettent une collaboration transparente et une innovation durable dans des entreprises de toutes tailles.

Prise en main

Des formations et des cours sont disponibles pour les étudiants, le monde académique, les professionnels et les entreprises. Trouvez la formation CATIA qui vous correspond.

Accès à l'aide

Obtenez des informations sur la certification des logiciels et du matériel, les téléchargements de logiciels, la documentation utilisateur, les coordonnées du support et l'offre de services.